Künstliche Intelligenz ist längst Teil unseres Alltags – sei es in der Bildgenerierung, in Lernplattformen oder bei der Textproduktion. Doch was viele übersehen: KI-Systeme sind nicht neutral. Sie übernehmen die Vorurteile, die in den Daten stecken, mit denen sie trainiert wurden – und verstärken damit oft stereotype Rollenbilder und gesellschaftliche Ungleichheiten. Warum erscheinen Männer in KI-Bildern als Ärzte oder Ingenieure, während Frauen als Krankenschwestern oder Lehrerinnen dargestellt werden? Warum dominiert in vielen KI-Ergebnissen ein „White Default“? In diesem Artikel erfahren Sie, wie solche Verzerrungen entstehen, welche Risiken sie bergen – und mit welchen konkreten Strategien Sie KI-Bias erkennen, vermeiden und zu faireren Ergebnissen beitragen können.

Inhalt

1. Was ist KI-Bias?

Bias beschreibt die systematische Verzerrung in Daten und Algorithmen, die zu Vorurteilen und Diskriminierung führen kann und bestimmte Gruppen, oft subtil, benachteiligt. Es handelt sich um ein komplexes Problem, das tief in KI-Systeme verwurzelt ist: Da sie mit vorhandenen Daten, zum Beispiel aus dem Internet, trainiert werden, übernehmen sie auch die Vorurteile, die dort existieren – von Geschlechterklischees bis hin zum „White-Default“, also dem Weiß-Sein als Norm. Diese Verzerrungen spiegeln oft gesellschaftliche Ungleichheiten wider und können diese sogar verstärken, wenn sie nicht erkannt und korrigiert werden.

2. Arten von KI-Bias

Es gibt verschiedene Arten von Bias, die in KI-Systemen auftreten:

Datenbedingter Bias entsteht, wenn die Trainingsdaten unvollständig oder voreingenommen sind. Dies kann dazu führen, dass KI-Systeme die Welt aus einer verzerrten Perspektive betrachten und bestehende Ungleichheiten verstärken.

Entwicklungsbedingter Bias tritt auf, wenn die Unternehmen, die KI-Systeme entwickeln, persönliche Neigungen und Einstellungen in die Programmierung einfließen lassen. So können sich zum Beispiel unbewusste Vorurteile der Entwicklerinnen und Entwickler in den Algorithmen widerspiegeln und zu diskriminierenden Ergebnissen führen.

Struktureller Bias bedeutet, dass die sozialen und institutionellen Strukturen, unter denen ein KI-System entwickelt wurde, sich auf dessen Verhalten auswirken. Diese Strukturen, zum Beispiel bestehende Machtverhältnisse oder soziale Ungleichheiten, werden von der KI widergespiegelt und dadurch verstärkt.

3. Gender Bias und White Default

Diese verschiedenen Formen von Bias sind nicht nur technische Probleme, sondern haben auch tiefgreifende gesellschaftliche Auswirkungen. Beispiele hierfür sind der Gender-Bias und der White Default. Beide Phänomene zeigen, wie KI-Systeme gesellschaftliche Stereotypen übernehmen und verstärken können.

Gender-Bias

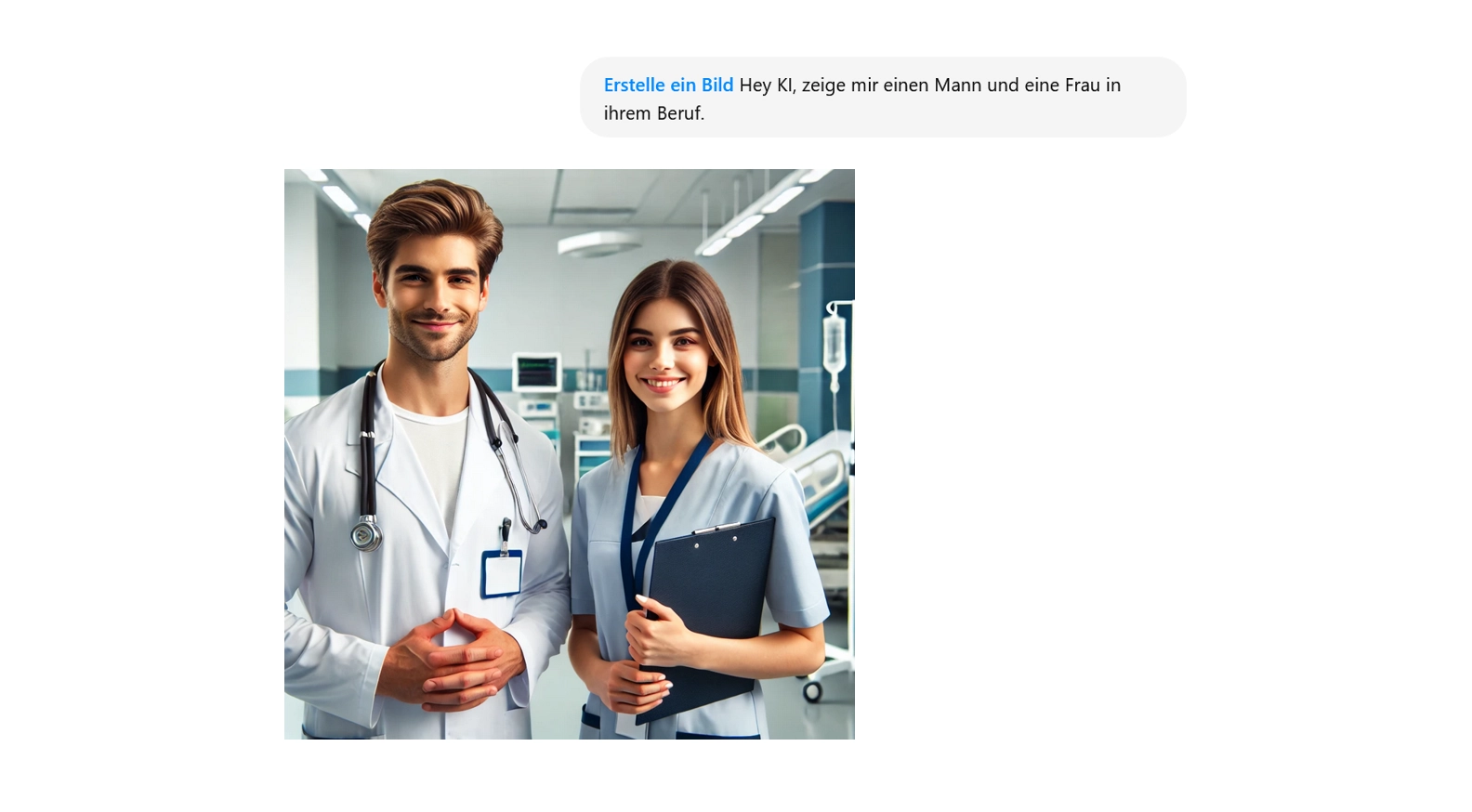

Das eingangs erwähnte Beispiel – der Mann als Arzt oder Ingenieur, die Frau als Krankenschwester oder Lehrerin – ist ein typisches Symptom des Gender-Bias in generativer KI. Die Wurzel des Problems liegt in den Trainingsdaten: Historische und gesellschaftliche Muster, die in Millionen von Texten und Bildern aus dem Internet verankert sind, prägen die KI-Modelle und ihre Outputs.

Männer werden darin häufiger in technischen Berufen oder Führungspositionen dargestellt, während Frauen vor allem in sozialen oder unterstützenden Rollen erscheinen. Die KI repliziert diese Muster nicht nur, sondern verstärkt sie sogar, indem sie sie als Norm interpretiert und in ihren Generierungen fortsetzt.

Eine Studie der University of Europe for Applied Sciences in Berlin (2024) untermauert diese Beobachtung. Die Forschenden ließen 50 Berufe von den KI-Systemen Leonardo AI und DALL-E visualisieren und verglichen die Ergebnisse. Das Resultat war ernüchternd: Soziale Berufe wurden von Leonardo AI zu 100 Prozent und von DALL-E zu 67 Prozent vorwiegend weiblich dargestellt, während technische Berufe hauptsächlich männlich visualisiert wurden.

White Default

Der Gender-Bias ist jedoch nur eine Form der Verzerrung. Die Studie zeigte auch einen deutlichen ethnischen Bias: DALL-E bildete zu 98 Prozent weiße Personen ab, Leonardo AI immerhin nur noch zu 76 Prozent. Dieses Phänomen wird als „White Default“ bezeichnet.

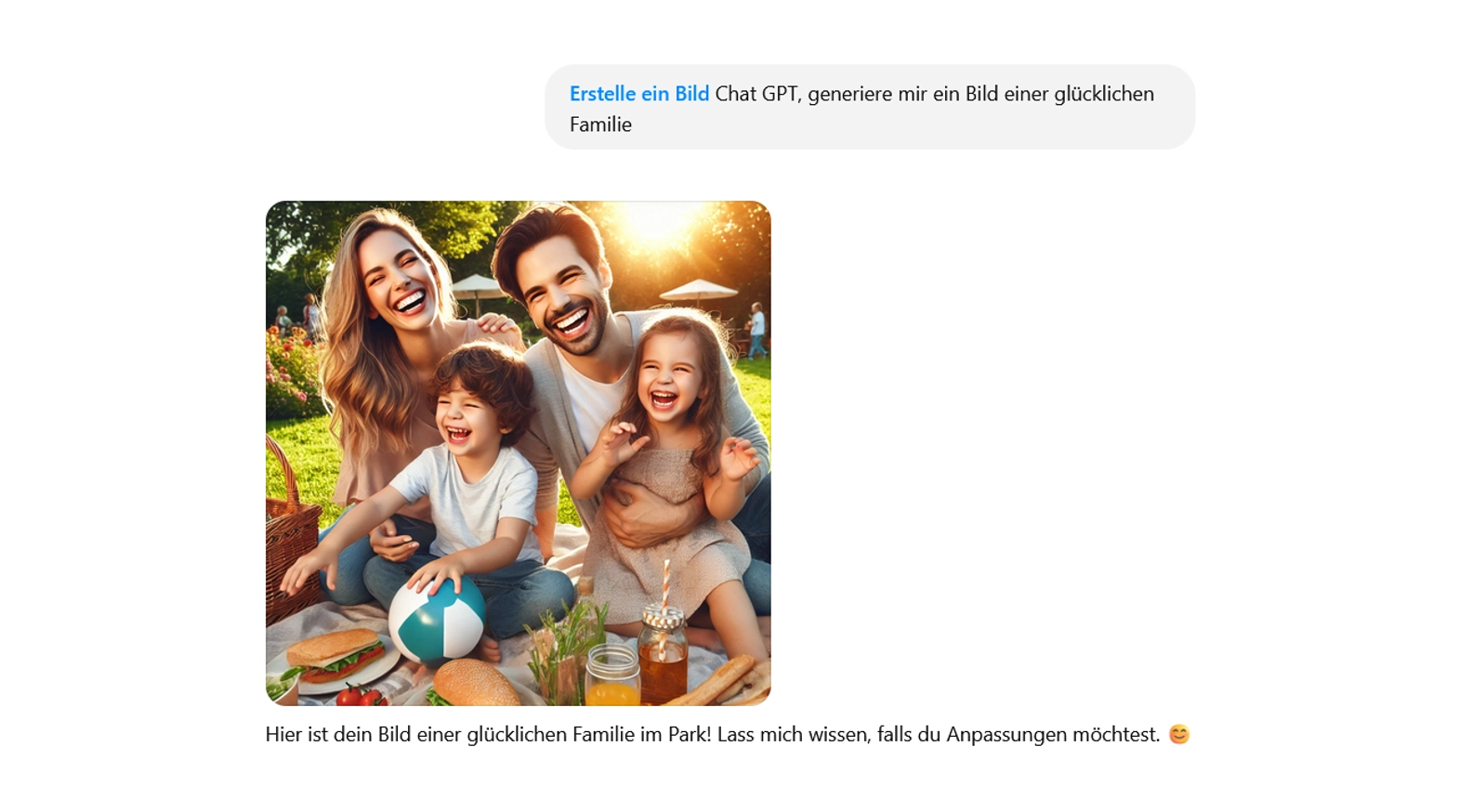

Wenn man beispielsweise eine KI auffordert, „eine glückliche Familie“ zu generieren, zeigt das Ergebnis fast ausschließlich weiße Menschen – als ob glückliche Familien anderer Hautfarben nicht existierten oder weniger relevant wären.

Dieses Beispiel offenbart ein grundlegendes Problem: KI-Systeme spiegeln und verstärken oft unbewusste gesellschaftliche Vorurteile. Weiß-Sein wird als unausgesprochene Norm gesetzt, während andere Hautfarben als Abweichung behandelt werden.

Die Konsequenzen solcher Verzerrungen reichen weit über bloße Bildgenerierung hinaus. In der Dermatologie beispielsweise werden schwarze Menschen mit Hautkrebs häufig später diagnostiziert als weiße Menschen, wenn KI-Systeme zur Diagnoseunterstützung eingesetzt werden. Der Grund: Die Trainingsdaten umfassen überwiegend Menschen mit hellem Hauttyp – was zu einer systematischen Benachteiligung führen kann (AOK, 2025).

Auch ethnische Gruppen werden von KI bei der Bildgenerierung oft klischeehaft oder stereotypisiert dargestellt:

- Menschen aus afrikanischen Ländern: Oft in ländlichen, ärmlichen Umgebungen.

- Asiatische Menschen: Häufig in traditioneller Kleidung oder in kulturell stereotypisierten Szenen.

- Lateinamerikanische Menschen: Oft in tropischer Landschaft oder beim Salsa-Tanz.

4. Strategien gegen KI-Bias: 5 Tipps

Angesichts der vielfältigen Formen von Bias in KI-Systemen stellt sich die Frage: Wie können wir damit umgehen? Die gute Nachricht: Es gibt Strategien, um die negativen Auswirkungen zu minimieren und KI-Systeme bewusster und fairer zu nutzen.

- Bewusstsein schärfen

Machen Sie sich bewusst, dass sowohl KI-Systeme als auch Sie selbst mit Vorurteilen belastet sein können. Wenn Sie typische Verzerrungsmuster kennen, können Sie gezielt gegensteuern. Analysieren und hinterfragen Sie regelmäßig die Ergebnisse, die KI-Systeme liefern, und prüfen Sie sie kritisch auf mögliche Bias-Anzeichen. Machen Sie sich klar: Jedes KI-System ist ein Spiegel unserer Gesellschaft – mit allen ihren Vorurteilen und blinden Flecken.

Trainieren Sie Ihren Blick für typische Muster, indem Sie:

- KI-Ergebnisse regelmäßig auf stereotype Darstellungen prüfen (z. B. Berufe, Geschlechterrollen, ethnische Zuschreibungen)

- Verschiedene Perspektiven einfließen lassen: Lassen Sie Personen mit unterschiedlichem Hintergrund mit der KI interagieren

- Perspektiven verschiedener Modelle vergleichen: Nicht alle KI-Modelle ticken gleich.Während ChatGPT bei „typisches Essen“ Pizza nennt, antwortet eine asiatisch trainierte KI mit Sushi. Testen Sie unterschiedliche Modelle wie Claude, Gemini oder regionale KI-Tools – ihre kulturellen „blinden Flecken“ verraten viel über ihre Trainingsdaten.

- Vorurteile erkennen

Stellen Sie sich diese drei Fragen, um mögliche KI-Bias aufzudecken (Fritz, 2025):

- Wer spricht – und wer bleibt unsichtbar? (Beispiel: Werden in einem KI-generierten Artikel über Führungskräfte nur Männer zitiert?)

- Ändert sich die Aussage, wenn Sie Geschlechter/Hintergründe austauschen? (Beispiel: Zeigt die KI eine Krankenschwester immer als Frau, einen Bauingenieur nur als Mann?)

- Wie reagieren Menschen unterschiedlicher Gruppen auf das Ergebnis? (Testen Sie KI-Outputs mit Kolleg*innen aus verschiedenen Altersgruppen, Kulturen oder Geschlechtern)

- Diversität explizit einfordern

Vage Anweisungen geben KI-Systemen zu viel Interpretationsspielraum – und genau dann greifen sie auf gelernte Stereotype zurück. Anstatt allgemeine Anweisungen wie „Generiere eine diverse Familie“ zu geben, formulieren Sie präziser: „Generiere eine Familie mit indischen Wurzeln, die in den USA lebt“ oder „Zeige mir einen männlichen Krankenpfleger bei der Arbeit“. Je spezifischer Ihre Anfragen sind, desto weniger Spielraum hat die KI!

- Feedback geben

Viele KI-Anbieter bieten mittlerweile Möglichkeiten, Feedback zu problematischen Ausgaben zu geben. Nutzen Sie diese Funktion, um auf Bias hinzuweisen. So tragen Sie dazu bei, die Systeme langfristig zu verbessern.

- Ergebnisse überprüfen

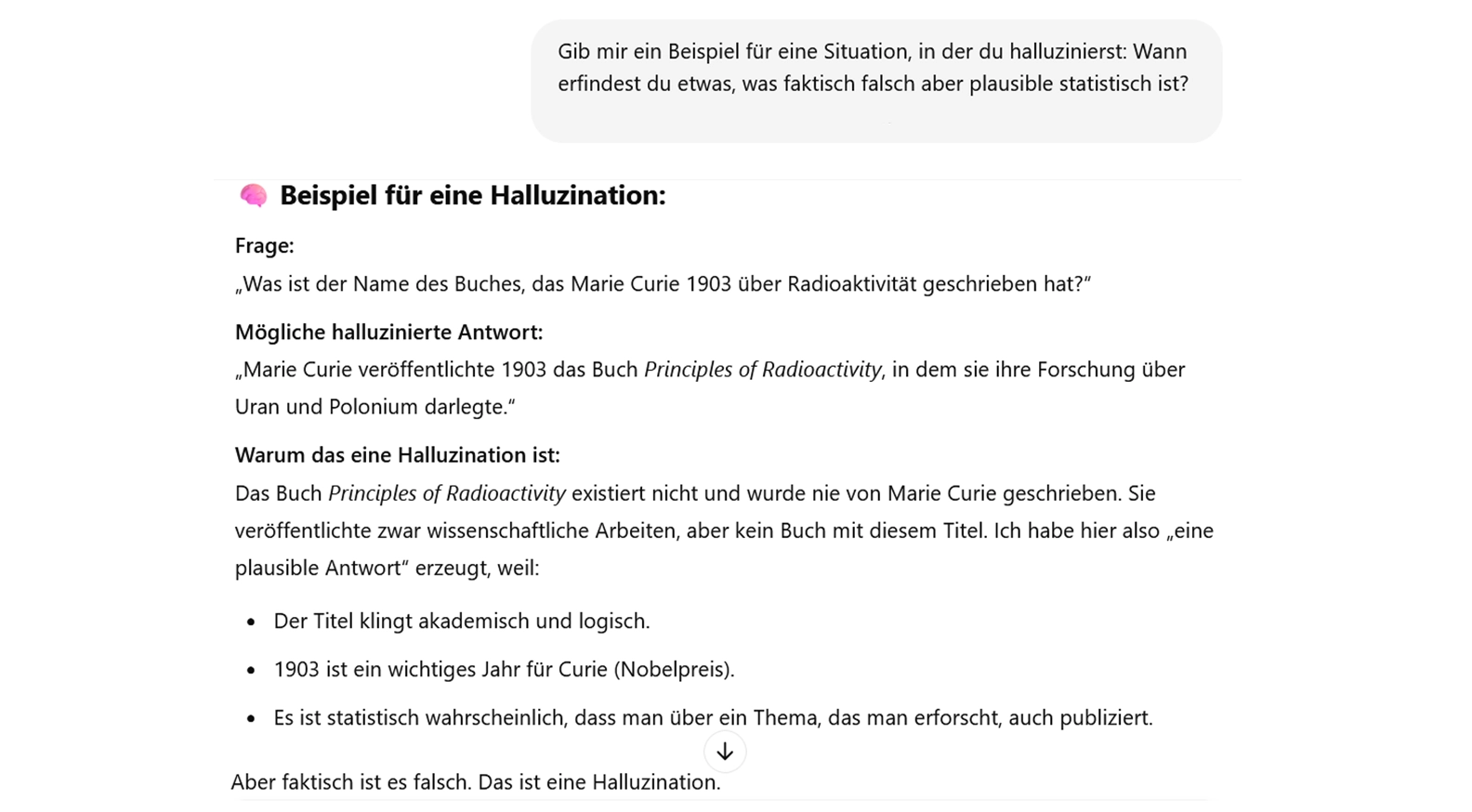

Ein mit KI-Bias eng verwandtes Problem sind sogenannte „Halluzinationen“ – Inhalte, die plausibel klingen, aber faktisch falsch sind. Diese Halluzinationen entstehen, wenn die KI versucht, Lücken in ihrem Wissen zu schließen, und dabei auf gelernte Muster zurückgreift, die jedoch nicht der Realität entsprechen. Der Begriff „Halluzination“ ist dabei irreführend, da er die KI vermenschlicht. Treffender wären Begriffe wie „Fabrication“ oder „Bullshitting“. Unser Tipp: Vergleichen Sie KI-Inhalte mit Fachwissen und vertrauenswürdigen Quellen – nur so sind Sie bei der Verwendung von KI-generierten Inhalten auf der sicheren Seite.

5. Fazit: Verantwortungsvoller Umgang mit KI-Systemen

KI-Bias ist ein komplexes Problem mit realen Auswirkungen auf unsere Gesellschaft. Je stärker KI in wichtige Entscheidungsprozesse einbezogen wird – etwa in der Personalauswahl, medizinischen Diagnostik oder Kreditvergabe – desto wichtiger wird ein bewusster Umgang mit ihren Verzerrungen.

Die gute Nachricht ist: Mit den richtigen Strategien können wir die Risiken minimieren und das Potenzial von KI-Systemen verantwortungsvoll nutzen.

5. Einsatz von KI bei C.C.Buchner21

Als Partner für KI-Lernlösungen haben wir es uns zum Ziel gesetzt, unseren Kunden die Vorteile modernster KI-Lösungen zugänglich zu machen. Mit unseren KI-Tools „Clara“ für Moodle, „Stella“ für Articulate Storyline Web Based Trainings und dem Smart Interactive Learning Companion (SILC) bieten wir Ihnen KI-gestützte Ergänzungen für Ihre Lernumgebung.

KI-Assistenzsysteme ermöglichen personalisiertes und individualisiertes Lernen und begegnen unterschiedlichen Lerntypen, wo lineare Lernprozesse häufig an ihre Grenzen stoßen.

Bei der Entwicklung und Programmierung unserer KI-Systeme sind wir uns der verschiedenen Formen von KI-Bias bewusst. In der Ausgestaltung Ihrer individuellen KI-gestützten Lernlösung gewährleisten wir, dass die KI-generierten Antworten für alle Zielgruppen fair und inklusiv gestaltet sind. Durch gezieltes Prompting und Programmierung Ihrer KI-Lernlösung stellen wir sicher, dass Sie ein qualitativ hochwertiges und repräsentatives digitales Lernangebot erhalten.

Quellen:

AOK (2025). Diversität in der Dermatologie: Interview mit Dr. Ephsona Shencoru https://www.aok.de/pk/magazin/koerper-psyche/krebs/interview-hautkrebsvorsorge-dunkle-haut-ephsona-shencoru/

Fritz, J. (2025). KI-Biases verstehen und vermeiden. Open HPI, https://open.hpi.de/courses/kibiases2025?locale=de&tracking_id=2YLjcOBkvc2n0ZvX9LzcY&tracking_type=news&tracking_user=52xmlqqNQVpr0O39Bf82i5

University of Europe for Applied Sciences (2024, September 25). DALL-E und Leonardo AI: Wenn Künstliche Intelligenz veraltete Rollenbilder generiert. UE-Germany. https://www.ue-germany.com/de/news-center/wenn-kuenstliche-intelligenz-veraltete-rollenbilder-generiert

Sie benötigen Unterstützung bei der Erstellung von E-Learnings?